![[图像编辑08] InstructPix2Pix](https://s2.loli.net/2025/03/26/3CNOKaX96eySw7n.png)

Table of Contents

InstructPix2Pix: Learning to Follow Image Editing Instructions Link to InstructPix2Pix: Learning to Follow Image Editing Instructions

From:CVPR2023

Motivation Link to Motivation

区别于前面的工作

- 这次的文本是“指令”

- 这次的训练数据集是生成的

Method Link to Method

Generating a Multi-modal Training Dataset

Generating Instructions and Paired Captions

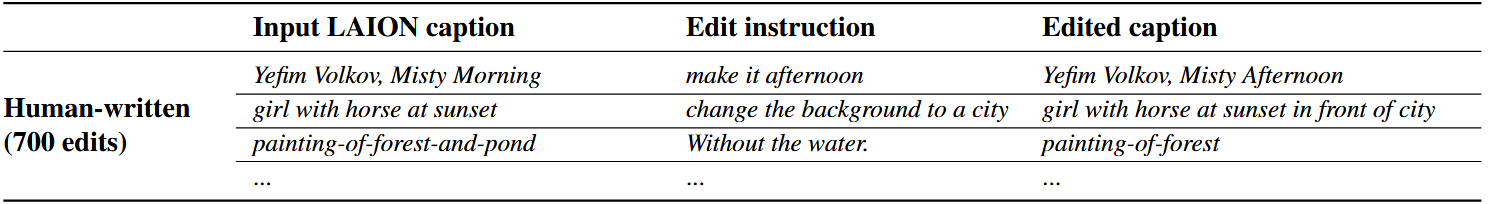

具体来说,首先是从LAION-Aesthetics V2 6.5+数据集采集了700个input captions,然后人工对这700个进行加工,得到一个三组的数据(1) input captions, (2) edit instructions, (3) edited captions

如图所示

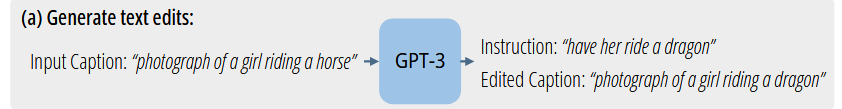

然后用700个数据微调GPT-3,让GPT学习只给input captions就生成edit instructions和edited captions

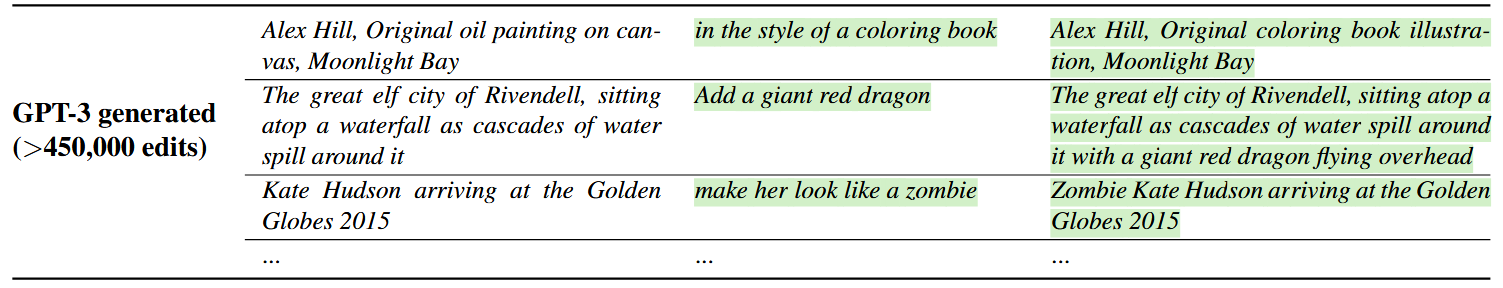

然后利用LAION的所有数据做input caption生成的结果就是

Generating Paired Images from Paired Captions

使用Prompt-to-Prompt,根据input captions和edited captions生成图片

使用CLIP-based mertic,衡量生成的前后图片的相似性,对低质量数据做过滤

InstructPix2Pix

最小化下面的损失函数

其中,是Encoder,是image conditioning,是text instruction conditioning

Pretraining is All You Need for Image-to-Image Translation认为,当训练数据有限,fine-tuning a large image diffusion models优于training a model from scratch for image translation tasks,所以本次是做fine tune。

Classifier-free Guidance for Two Conditionings

关于原来的class-free guidance,是在训练的时候联合了有条件去噪和无条件去噪,并在推理的时候结合这2个分数估计

推理时设置,即可倾向有条件去噪

本文借鉴Compositional Visual Generation with Composable Diffusion Models,融合2个条件,分数估计改为

其中,、分别代表了原图和edited instruction对生成图片的控制度

[图像编辑08] InstructPix2Pix

© JuneSnow | CC BY-SA 4.0