Table of Contents

Self-Forcing++: Towards Minute-Scale High-Quality Video Generation Link to Self-Forcing++: Towards Minute-Scale High-Quality Video Generation

https://arxiv.org/pdf/2510.02283

摘要 Link to 摘要

生成扩展到长视频时,DiT高昂计算成本。

近期的工作探索了用于长视频生成的自回归形式,通常通过从短时域(short-horizon)双向教师模型中进行蒸馏来实现。然而,鉴于教师模型无法合成长视频,学生模型在其训练时域之外的外推(extrapolation)通常会导致明显的质量下降,这源于连续潜在空间内的误差累积。

在本文中,我们提出了一种简单而有效的方法,以减轻长时域视频生成中的质量下降,且无需来自长视频教师模型的监督,也无需在长视频数据集上重新训练。

我们的方法核心在于利用教师模型的丰富知识,通过从自生成的长视频中抽取的采样片段为学生模型提供指导。

我们的方法在保持时间一致性的同时,将视频长度扩展至超出教师模型能力的 ,避免了过曝和误差累积等常见问题,且无需像以往方法那样重新计算重叠帧。

1 引言 Link to 1 引言

随着扩散模型的出现,视频生成领域正以惊人的速度发展。Sora [43]、Wan [56]、Hunyuan-DiT [29] 和 Veo [13] 等开创性工作正在逐步缩小生成内容与现实之间的差距。尽管取得了这些进展,但仍存在一个巨大的挑战:大多数最先进的模型仅限于生成短视频,通常上限为 秒。这种限制是底层 Diffusion Transformers (DiT) [45] 架构设计所固有的,原始 DiT 架构本质上的非流式和非因果性质对实现时间可扩展性构成了重大挑战。

超越这一限制的一个有前景的途径在于从双向扩散架构转向自回归、基于流的模型。

其中一种方法 Diffusion Forcing [5, 25],在帧之间应用异构噪声调度以实现序列生成。

然而,噪声调度的组合复杂性通常导致训练不稳定,并且已被证明难以扩展 [6, 15]。一个更易处理的策略涉及从干净的上下文中预测下一帧或数据块,其中 KV 缓存已成为实现高性能、实时流传输的关键机制。

例如,CausVid [69] 提出了一种使用异构蒸馏将双向教师模型蒸馏为流式学生模型的方法。然而,它依赖重叠帧来保持时间一致性,以及明显的训练-推理不匹配,通常会导致过曝伪影。

Self-Forcing [21] 方法通过对齐训练和推理分布来减轻过曝问题。虽然这为短视频质量设定了新的基准,但其能力仍然受到固定时长的教师模型的限制。因此,当任务是生成超出此内在时间窗口(例如 秒)的内容时,模型的视觉质量会急剧下降。

限制自回归长视频生成模型质量的一个主要挑战是显著的“训练-推理不匹配”。这种不匹配主要表现在两个方面。

首先是“时间不匹配”:在训练期间,模型生成长达 秒的短片段——这是教师模型的最大时域——而在推理时,它们必须生成长度显著更长的视频。

其次是长时域生成过程中由“监督不匹配”引起的误差累积。在训练中,教师模型为短片段内的每一帧提供了丰富的监督。然而,这种密集的指导意味着学生模型很少接触到长序列生成(rollouts)中自然出现的复合误差,使其无法应对这些误差。结果,生成质量在超过 秒的训练时域后迅速恶化,通常崩溃为静态或停滞的内容。

在本文中,我们介绍了 Self-Forcing++,它直接针对上述两个问题。

基于先前工作 [1, 3, 31] 的观察,即教师模型尽管自身有 秒的生成限制,但由于其在海量视频语料库上的训练,它拥有纠正质量下降视频中误差的丰富知识。我们利用这一见解,将学生的生成时域扩展到远超 秒(在我们的实验中高达 秒)。

这个过程有意产生包含累积误差的候选长视频。为了使学生模型能够处理这些误差,我们随后将噪声重新注入到这些退化的生成序列中,并应用与强教师模型的分布匹配蒸馏,这一过程结合了长时域滚动 KV 缓存和窗口采样。这种策略教会学生从退化状态中恢复,并在延长的持续时间内维持高质量、连贯的视频生成。

实验结果表明,我们的方法可以将视频生成扩展到 秒,相对于基线增加了 ,同时保持高视觉质量。通过扩展训练来扩大计算规模,我们的方法能够生成长达 分 秒的视频,利用了基础模型位置嵌入容量的 ,相比基线提升了 。此外,我们的调查显示,广泛使用的 VBench 基准在评估长视频时存在偏差,偏向于过曝和退化的帧,从而破坏了其结果的可靠性。为了解决这个问题,我们提出了一种新的指标——视觉稳定性(Visual Stability),旨在系统地捕捉长视频生成中的质量下降和过曝问题。我们的工作为构建更健壮、更可靠的长视频生成模型铺平了道路。

我们的贡献总结如下:

识别时域扩展瓶颈:我们揭示了扩展自回归模型生成时域的主要障碍:训练与推理期间在时间性和监督方面的双重不匹配。这一见解为克服以往在生成长度上的限制提供了明确的目标。

一个简单的解决方案:我们提出了一个简单的训练框架,名为 Self-Forcing++。通过生成超出教师时域的内容,并在学生模型自身长的、包含累积误差的生成轨迹上对其进行修正,Self-Forcing++ 将高质量视频生成扩展到了 秒,在不重用重叠帧的情况下远远超越了以往的最先进方法。

SOTA 性能和时域可扩展性:Self-Forcing++ 在各种时长(例如 s、s、s)的长视频生成中均实现了最先进(SOTA)的性能。此外,我们发现了一个显著的扩展特性:通过扩展训练计算量,我们模型的生成能力扩展到了数分钟,这是以前被认为无法实现的壮举。

2 相关工作 Link to 2 相关工作

长视频生成

由于基于 DiT 架构的巨额训练和推理成本,大多数最先进的模型仍然仅限于生成 秒的视频。为了克服这一限制,已经引入了许多技术来将生成扩展到更长的持续时间 [12, 23, 28, 34]。

- RIFLEx [71] 是一种免训练的方法,它重新审视了位置编码,通过避免引起重复动作的编码,有效地使视频长度加倍,并大幅超越了之前的方法 [7, 46, 72]。另一个有前景的方向是自回归视频生成。

- Nova [10] 将视频生成重新表述为一个非量化的自回归问题,联合建模时间上的逐帧预测和空间上的逐组(set-by-set)预测,从而实现了灵活的上下文学习。

- Pyramid-Flow [24] 将去噪解释为跨越多级金字塔的层级过程,连接跨分辨率和时间的流,以支持使用单个扩散 Transformer 进行端到端自回归视频生成。

- SkyReels-V2 采用扩散强制(diffusion forcing)[5] 来支持潜在的无限生成(rollouts),

- 而 MAGI-1 [54] 训练一个模型来逐步去噪随时间增加的每块(per-chunk)噪声,自回归地预测连续帧的固定长度片段。

- CausVid [69] 采用块因果注意力(block causal attention)和 KV 缓存来自回归地扩展序列,

- 而 Self-Forcing [21] 通过在训练期间直接合并 KV 缓存,进一步将训练与推理对齐,从而生成高质量的短视频。

3 方法 Link to 3 方法

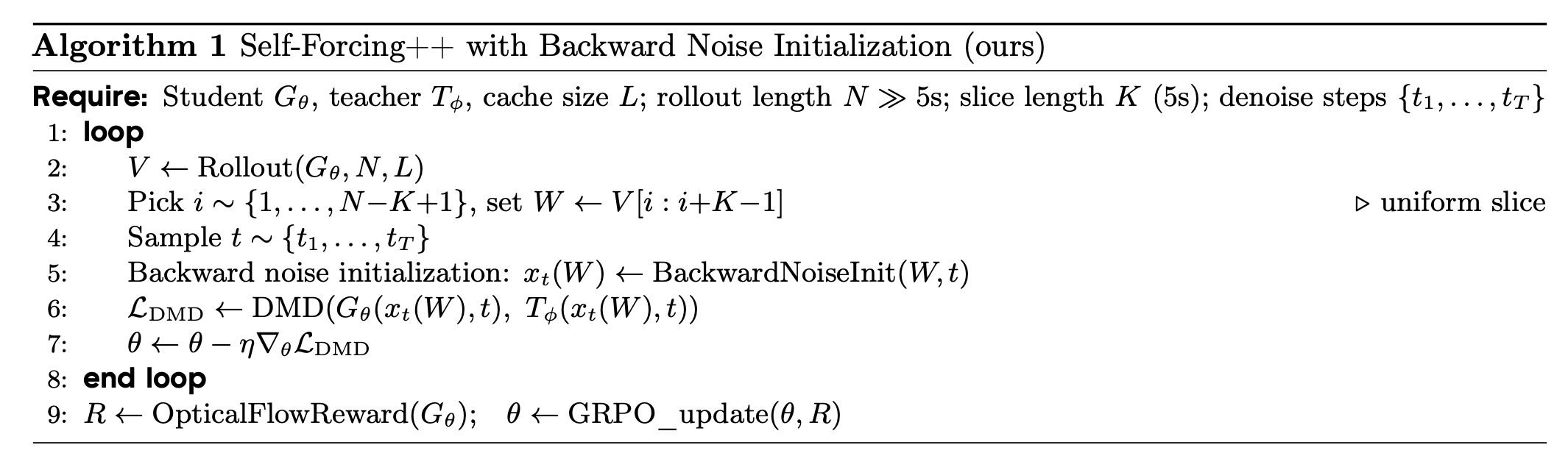

本节详细介绍了我们用于长视频生成的方法。我们首先回顾将双向模型转换为流式自回归生成器的方法 [21, 69]。在此基础上,我们介绍了专为长视频合成量身定制的新策略。完整的生成过程在算法 1 中形式化。

3.1 背景 Link to 3.1 背景

视频扩散模型虽然强大,但通常需要沿着多步噪声调度进行去噪,这使得生成过程计算密集。

减轻这种计算负担的一个流行策略是将基础模型蒸馏为少步生成器。

该领域的主要方法包括分布匹配 (DM) [41, 67, 68] 和一致性模型 (CM) [53, 57]。

基于 CausVid 和 Self-Forcing 的方法,我们将原始的双向教师模型蒸馏为少步生成器,然后将其转换为自回归模型。这种转换是通过训练学生模型来复制从教师模型采样的常微分方程 (ODE) 轨迹来完成的。我们将此过程称为初始化阶段(实施细节见第 8.3 节)。

Self-Forcing 方法通过使用诸如分布匹配蒸馏 (DMD) 损失 [67] 等技术,在长达五秒的自生成序列(rollouts)上训练蒸馏模型来扩展此方法。

虽然这种技术有效地减轻了 CausVid 中存在的过曝伪影,但在生成超出其受限训练时域的序列时,它表现出生成质量的严重下降。

3.2 扩展训练至超越教师模型的限制 Link to 3.2 扩展训练至超越教师模型的限制

动机 Link to

如前所述,教师模型仅在五秒的视频片段上进行训练。

因此,基于蒸馏的方法(如 CausVid [69] 和 Self-Forcing [21])仅在这个有限的时间窗口内强制执行学生-教师分布对齐。

当生成扩展到这五秒时域之外时,这种受限的训练目标会导致质量急剧下降。

尽管性能崩溃,我们做出了一个关键观察:超出训练时域生成的视频通常保留结构连贯性,即使这种连贯性表现为不良的伪影,如运动停滞(Self-Forcing 中常见的故障模式)。

这表明核心问题并不是自回归机制的根本性崩溃,该机制正确地利用了历史 KV 缓存来维持上下文。

相反,主要问题是扩展生成序列期间的自回归误差复合。

这些误差累积并最终表现为运动丢失、场景冻结和视觉保真度的灾难性下降。

这一见解促使我们引入一种简单而有效的方法来减轻误差累积,如下文所述。

后向噪声初始化 Link to

将师生蒸馏扩展到长时域视频生成的一个核心挑战在于噪声初始化策略。

在短时域设置中(即长度达到 帧的视频),可以直接在从教师模型采样的完整轨迹上监督学生模型,每个轨迹都源自随机噪声。

然而,对于长时域生成,从纯随机噪声初始化的轨迹与之前的视频内容解耦,导致根本性的上下文不匹配,因为采样的噪声不保留先前生成帧的时间依赖性。

基于上述观察,我们将噪声添加回已去噪的潜在向量中,并将其用作起始噪声,这也显示出能提升蒸馏性能 [67]。

虽然在先前的工作中采用了类似的重新注入噪声技术,但我们的动机和应用是截然不同的。

他们将其用于短视频蒸馏,主要是为了提高单次生成的质量或规避对真实训练数据的需求。

我们利用它作为一种机制来强制长视频的时间一致性。

具体来说,学生模型首先展开为 帧的序列,其中 ,这里 表示教师可以可靠生成的最大时域,如 秒。然后我们根据相同的扩散噪声调度 将噪声重新注入到学生的生成序列中。

形式上,给定学生生成的干净轨迹 ,生成被扰动为:

其中 表示高斯噪声, 是由 参数化的噪声预测网络,它作为计算教师和学生分布的初始状态。

这种方法确保了学生和教师模型之间的分布差异是在保留时间一致性并根据规定的噪声调度正确结构的轨迹上进行评估的。

扩展分布匹配蒸馏 Link to

我们将训练扩展到长视频的策略基于这样的观察:尽管双向教师模型仅在短的五秒片段上进行训练,但它隐含地从其训练数据中捕捉了“世界”的基础数据分布。

从这个角度来看,任何短的、连续的视频片段都可以被视为来自有效的、更长视频序列的边缘分布的样本。

这种直觉激发了我们的核心方法扩展。

由于我们的基线方法 Self-Forcing 将训练持续时间限制在前 帧(通常 秒),我们指示学生模型展开到 帧,其中 。

然后,我们从生成的序列中均匀采样一个长度为 的连续窗口,并计算该窗口内学生和教师模型之间的分布差异。此滑动窗口蒸馏过程形式化为方程 (2):

这里, 表示给定潜在 的学生生成器展开序列, 是时间步 的变换过程。 和 分别表示时间 的学生和教师分布,具有相应的分数 和 。

我们从长度为 的学生生成序列中均匀采样起始索引 ,并提取长度为 的窗口。

然后训练学生以最小化该窗口内其分布与教师分布之间的平均 KL 散度。窗口大小 通常选择为与教师模型最初训练生成的时域相匹配。

备注

双向扩散可以看作是在不同的去噪时间步逐步恢复退化目标的过程。

我们的方法将这一想法调整为自回归视频生成机制,让短时域教师在不同的时间帧逐步恢复学生的退化生成序列,然后将这些修正知识蒸馏回学生模型中。

使用滚动 KV 缓存训练 Link to

尽管在推理时使用了 KV 缓存,CausVid [69] 仍然依赖于重新计算重叠帧,并遭受严重的过曝问题。

Self-Forcing [21] 试图解决这个问题,但通过在训练期间使用固定缓存而在推理时使用滚动缓存,引入了训练-推理不匹配。

虽然通过掩盖第一个潜在帧部分缓解了这种情况,但这种不匹配仍然导致长视频中大量的误差累积和时间闪烁(见图 4)。

相比之下,我们的方法通过在训练和推理期间均采用滚动 KV 缓存,自然消除了这种不匹配。

在训练时,此缓存用于展开远超教师监督时域的序列,以计算如上详述的扩展 DMD。

因此,我们的方法极大地简化了整个过程,既不需要重新计算重叠帧,也不需要潜在帧掩码。

3.3 通过 GRPO 改善长期平滑度 Link to 3.3 通过 GRPO 改善长期平滑度

采用滑动窗口或稀疏注意力机制进行长序列生成的生成模型的一个常见缺点是长期记忆的逐渐丧失。

这种退化通常表现为时间不一致性,例如物体突然出现或消失,或不自然的快速场景转换。

尽管我们上述提出的方法已取得了显著成果,但我们表明,当出现此类现象时,可以在自回归视频生成框架中使用群相对策略优化 (Group Relative Policy Optimization, GRPO),这是一种强化学习技术 [35, 64]。

每步的重要性权重 ,其中 表示在时间步 输出 的策略函数,可以根据方程 (1) 计算;而整体生成概率可以计算为当前自回归生成序列中所有对数概率的总和,我们在第 8.4 节中对此进行了展示。

为了引导优化过程朝着时间平滑的输出发展,我们遵循先前的工作 [4, 42],并使用连续帧之间光流的相对幅度作为运动连续性的代理。

3.4 用于长视频评估的新指标 Link to 3.4 用于长视频评估的新指标

大多数先前的工作依赖 VBench [22] 来评估长视频生成中的图像和美学质量。

然而,我们发现过时的评估模型使得该基准偏向于过曝的视频(例如 CausVid)和质量下降的长视频(例如 Self-Forcing),导致分数不准确。

为了解决这个问题,我们采用了 Gemini-2.5-Pro [9],这是一个具有强大推理能力的最先进视频多模态大语言模型 (video MLLM) [8, 38]。

我们的协议定义了关键的长视频问题,如过曝和误差累积,提示 Gemini-2.5-Pro 沿这些轴对视频进行评分,并将结果汇总到一个名为视觉稳定性(visual stability)的 量表上,以便进行一致的比较。更多细节在图 3 和第 8.5 节中提供。

Self-Forcing++

© JuneSnow | CC BY-SA 4.0